北京时间3月27日凌晨,阿里巴巴集团旗下的通义千问团队发布了其最新旗舰模型——Qwen2.5-Omni。这款端到端多模态模型专为广泛的人工智能感知应用而设计,能够高效处理文本、图像、音频和视频等多种数据形式,并通过实时流式响应同时生成高质量的文本输出和自然语音合成结果。

作为通义千问系列的重要更新,Qwen2.5-Omni在多个维度上实现了显著突破。它不仅支持丰富的多模态输入,还能在处理复杂任务时展现出色的性能表现。目前,该模型已通过Hugging Face、GitHub、ModelScope和DashScope等多个平台实现开源开放,用户可以通过在线Demo体验其互动功能,或直接使用QwenChat进行语音和视频聊天,感受这一全新模型的强大能力。

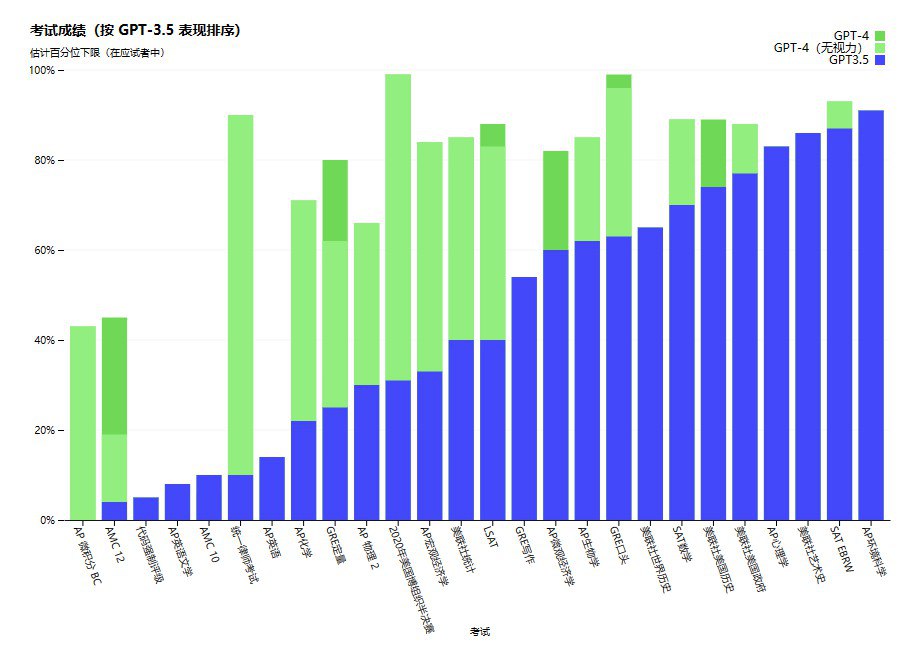

值得注意的是,Qwen2.5-Omni在图像、音频、音视频等多模态任务上的表现均优于同规模的单模态模型及封闭源模型。在权威的多模态评估基准OmniBench测试中,该模型达到了当前最优(SOTA)水平,充分展现了其卓越的技术实力和广泛的应用潜力。

这一最新发布再次彰显了通义千问在人工智能领域的技术领先地位,同时也为开发者和用户提供了一个强大的工具,助力多模态应用的创新与发展。